DeepMind最新研究:Chinchilla模型参数数量仅为Gopher模型的四分之一,...

作者: DeepTech深科技

| 发布于: | 雪球 | 转发:0 | 回复:0 | 喜欢:0 |

在过去的几年里,大型语言模型(LLM)的规模取得了系列重要进展, 使其在自然语言处理中表现出越来越出色性能。

例如,DeepMind 最近展示的 Gopher 模型已经拥有 2800 亿参数,在语言建模、阅读理解和问答等任务中展现了领先的性能。而在此之后不久,名为“Megatron-Turing NLG” 的语言模型紧随其后发布,其参数量达 5300 亿个。

(来源:DeepMind)

迄今为止,大型语言模型训练发展的主要趋势是增加模型大小,通常并不会增加训练标记的数量。而语言模型的参数数目增长,也意味着相应地要付出更多的投资。

最近,来自 DeepMind 的一项研究发现,近年来,尽管这些大型语言模型随着模型规模的增长,已经实现了性能的大幅增强。但由于训练它们的数据量并没有相应成比例地增加,这些大型语言模型并没有实现最高的投入产出比。换言之,目前许多参数众多的大型语言模型,存在训练不足的缺陷。

这以研究结果被发表在题为《经过计算优化的大型语言模型的训练》(Training Compute-Optimal Large Language Models)的论文中。在该论文中,DeepMind 的研究团队围绕着这样的问题进行探索,即:在给定的固定 FLOPs 预算的前提下,应该如何在模型规模(或模型参数数量)的大小和训练数据量之间进行权衡?

针对这一问题,研究团队基于在训练数据量范围从 5 到 5000 亿不等、参数数量范围从 7000 万到 160 亿不等、超过 400 次训练的运行结果出发,对模型规模大小和训练持续时间之间的关系提出了三种预测方法进行优化。

这三种方法分别是:固定模型的大小,并对训练标记的数量进行调整;针对 9 个不同训练 FLOP,调节模型大小;拟合出参数损失函数,也就是将前两个方法的所有最终损失,建模作为模型参数数量和训练数据量之间的函数。通过这三种不同的预测方法,都得到了同样的结果,即模型大小每增加一倍,训练数据集大小也应当相应地加倍。

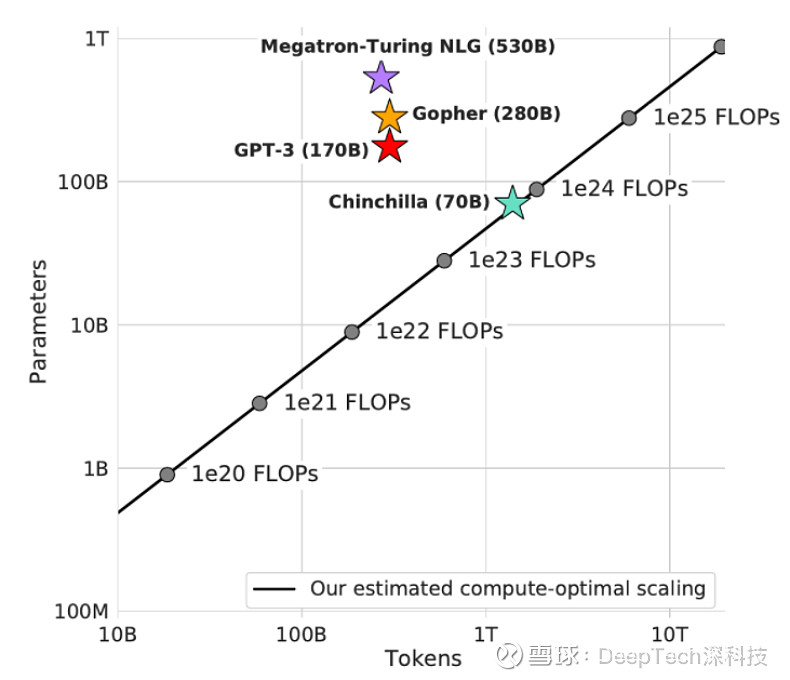

图 | DeepMind 研究团队发现的训练数据量与模型参数数量之间的最佳关系的预测(来源:DeepMind)

图 | DeepMind 研究团队发现的训练数据量与模型参数数量之间的最佳关系的预测(来源:DeepMind)

基于该结果,目前包括 DeepMind 发布的 Gopher 模型在内的许多大型语言模型,在大幅增加模型参数量的同时,并没有相应成比例地增加训练数据量,这是对于计算成本的巨大浪费。

事实上,该研究团队发现,对于 Gopher 所花费的成本来说,训练的数据量应当是其 4 倍才可真正实现计算预算的最大价值。也可以说,要想达到 Gopher 的性能,实际上只需要 Gopher 模型参数量的四分之一的模型已经足够。

在这一发现的基础上,研究人员进一步对名为“Chinchilla”的模型进行了训练,其训练数据量是 Gopher 的 4 倍,但参数数量仅是 Gopher 模型四分之一(700 亿个)。

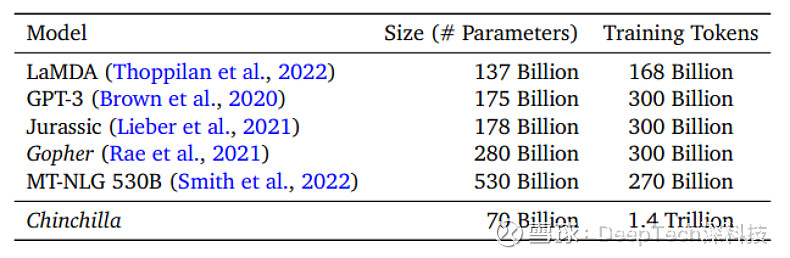

图 | Chinchilla、Gopher等语言模型的参数数量,训练数据量 (来源:Deep Mind)

图 | Chinchilla、Gopher等语言模型的参数数量,训练数据量 (来源:Deep Mind)

随后,研究人员将 Chinchilla 与其他大型语言模型在性能上进行对比,相关结果也验证了研究团队的结论。

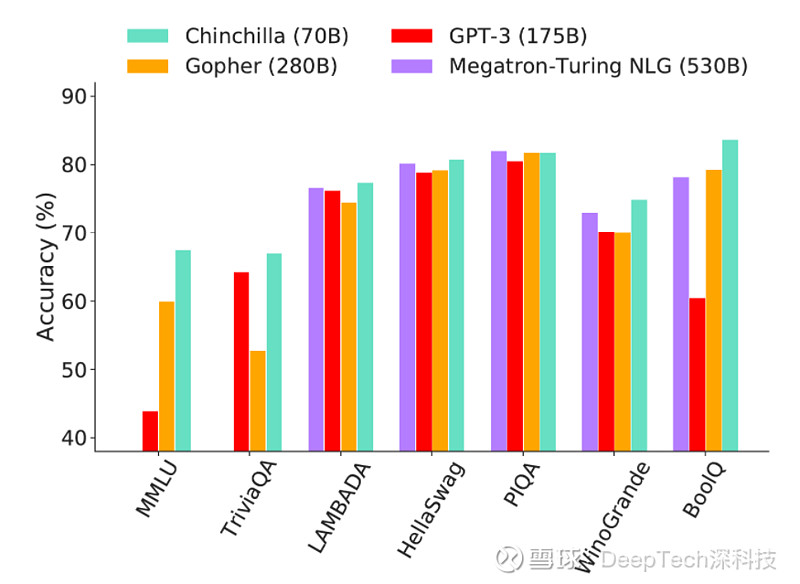

图 | Chinchilla 与 Gopher、GPT-3 和 Megatron-Turing NLG 等大型语言模型在问答能力 、常识、阅读理解和大型多任务语言理解能力的常见基准测试的测试结果对比(来源:DeepMind)

图 | Chinchilla 与 Gopher、GPT-3 和 Megatron-Turing NLG 等大型语言模型在问答能力 、常识、阅读理解和大型多任务语言理解能力的常见基准测试的测试结果对比(来源:DeepMind)

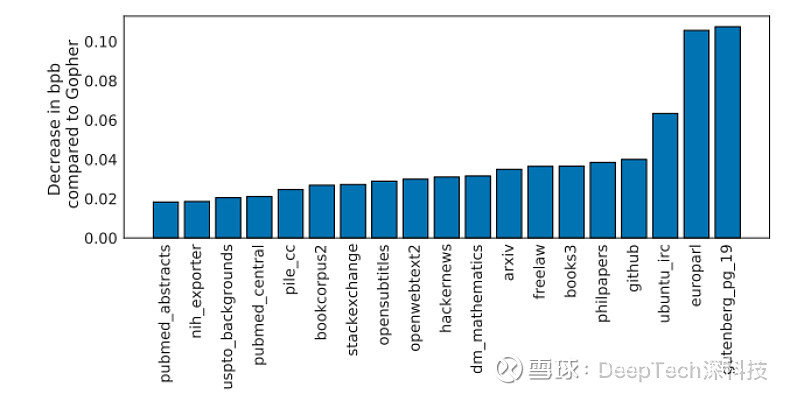

在语言建模方面,在对 Chinchilla 和 Gopher 模型进行语言建模方面权威的 Pile 测评之后,结果表明,参数数量更少的 Chinchilla 在所有评估子集上的表现,都显著优于 Gopher。例如在 Wikitext103 方面,Chinchilla 的困惑度为 7.16,而 Gopher 的困惑度则为 7.75。

图 | Chinchilla 和 Gopher 模型在语言建模Pile测评的表现差异。在所有评估子集上,Chinchilla 的表现都优于 Gopher(来源:DeepMind)

图 | Chinchilla 和 Gopher 模型在语言建模Pile测评的表现差异。在所有评估子集上,Chinchilla 的表现都优于 Gopher(来源:DeepMind)

而在大规模多任务语言理解(MMLU)方面,Chinchilla 模型在相关测试结果也明显优于 Gopher,该测评是包含一系列与学术科目类似的考试问题的 MMLU 基准测试。Chinchilla 的平均准确率达 67.6%,与 Gopher 的准确率相比,超出 7.6%。值得注意的是,Chinchilla 的准确率比专家预测的、在 2023 年 6 月才会实现的 63.4% 还高。

此外,Chinchilla 在 4 个不同的单独任务上达到了超过 90% 的准确率,它们分别是高中政府与政治、国际法、社会学和美国对外政策。而目前还没有其他模型在 MMLU 测试的子集上达到 90% 以上的准确率。

此外,Chinchilla 在阅读理解、常识、闭卷问答、性别平等与有毒性语言、性别偏见等方面的测评结果也优于 Gopher。

尽管随着计算能力的增强,语言模型的规模可以做得越来越大。但是,DeepMind 的分析表明,增加语言规模的大小,需要更加关注训练数据集相应的缩放。DeepMind 指出,在对训练数据集进行扩展时,还需要对更大的数据集高度责任,并重点关注数据集的质量,尤其是其中的伦理和隐私等问题。

-End-

参考:网页链接